KI und die Cybersecurity-Landschaft

In den letzten Monaten wurden unzählige Artikel über die neuen KI-Chatbots veröffentlicht, und seit diese Bots der Öffentlichkeit zugänglich sind, gab es viele interessante und spannende Demonstrationen, die auf diesen Systemen aufbauten.

Aber, und es gibt immer ein "aber", es gibt einige sehr besorgniserregende Überlegungen aus der Perspektive der Cybersicherheit, sowohl bei der Infrastruktur der Bots selbst als auch bei den (missbräuchlichen) Anwendungen, die von ihnen ausgehen können.

Chat-"Bots" oder einfach nur sehr glückliche Glücksspieler?

"Bots" ist ein Begriff, der viele Implikationen hat. Aus unserer kollektiven Erfahrung mit Robotern, zunächst mit Science-Fiction-Beispielen und dann mit den tatsächlich in verschiedenen Branchen eingesetzten Robotersystemen, "erwarten" wir, dass (Ro-) "Bots" zumindest in der Lage sind, autonome, sich wiederholende Aufgaben auf vorhersehbare Weise auszuführen.

Chatbots hingegen verhalten sich etwas anders. An einem Tag fragt man sie vielleicht nach "einer Einführung in den nächsten Moby Dick" und erhält ein Ergebnis, und am nächsten Tag - oder auch nur zwei Minuten später - erhält man mit der gleichen Frage völlig andere Ergebnisse. Das ist nicht das Verhalten, das man von Bots erwartet.

Warum ist das so, werden Sie sich fragen? Nun, es stellt sich heraus, dass "Chatbots" in ihrem Kern glorifizierte Sprachmodelle für maschinelles Lernen sind. Vereinfacht gesagt, sind sie sehr gut darin, Regeln wie "Grammatik" zu erkennen und zu "erraten", welches "Wort" in einem bestimmten Kontext wahrscheinlich folgen wird. Sicherlich haben Sie bemerkt, dass "Grammatik", "Erraten" und "Wort" zwischen " " stehen. Das liegt daran, dass der Begriff für ähnliche Regeln in der Bild-, Ton- oder Videobearbeitung gilt - genau wie für Text. Das gleiche Konversationsmodell, das der aktuellen Generation von Chatbots zugrunde liegt, ist genauso gut in der Lage, ein Bild auf eine Eingabeaufforderung hin zu erzeugen wie einen Textabsatz. Es geht nur um die Regeln und darum, zu erraten, was am besten zu diesen Regeln passen würde.

Wie lassen sich also unterschiedliche Antworten auf dieselben Aufforderungen erklären? Nun, das "Raten", was als Nächstes kommt, ist genau das - das Betrachten von Wahrscheinlichkeiten und das Finden der besten Lösung für eine bestimmte Aufforderung. Und das kann und wird sich im Laufe der Zeit ändern, wenn der Bot mit mehr Daten trainiert oder menschliche Interaktionen den Wert einer bestimmten Antwort gegenüber einer anderen verringern, oder sogar der einfache Zufall tut sein Übriges. Jeder, der schon einmal in einem Casino gespielt hat, weiß, dass eine Gewinnchance von 90 % immer noch bedeutet, dass man in 10 % der Fälle verlieren wird.

Die Bots sind außerordentlich gut darin, die Regeln zu lernen.

Die Regeln des Spiels

Die Cybersicherheit ist im Grunde ein regelgebundenes Spiel. Es gibt Systeme/Software/Menschen, die eine Reihe von Regeln befolgen, und es gibt eine andere Gruppe von Systemen/Software/Menschen, die versuchen, die Regeln der ersten Gruppe zu ihrem Vorteil auszunutzen.

Nehmen wir zum Beispiel Spam- und Phishing-E-Mails. Jeder kennt sie, jeder erhält sie, und hoffentlich halten die Spam-Filter die meisten davon fern, aber die eine oder andere bricht immer noch durch. Die Spam-Filter suchen nach verräterischen Anzeichen dafür, dass es sich bei einer E-Mail um Spam handelt - sie wenden eine Reihe von Regeln und die E-Mails, die durchkommen, schaffen es, diese Regeln zu brechen oder zu umgehen. Egal, ob Spam-Filter explizite Regeln haben, die die zu blockierenden E-Mails definieren, oder ob sie auf einer ausgeklügelten Heuristik basieren, es handelt sich immer noch um dieselben Regeln. Im zweiten Fall erstellen Sie die Regeln nur nicht direkt.

Ein Grund dafür, dass Spam-E-Mails relativ leicht zu erkennen und zu blockieren sind, liegt in den (vielen) offensichtlichen grammatikalischen Fehlern - nein, Ihre Bank will nicht "Ihre Kreditkartennummer und Verifizierungsnummer". So konnten Sie E-Mails einfach durch eine Rechtschreibprüfung des Textes kennzeichnen, den sie enthielten.

Aber jetzt können frei verfügbare Bots Texte schreiben, die keine solchen Fehler enthalten. Wir könnten von der Kennzeichnung schlecht geschriebener E-Mails zur Kennzeichnung von E-Mails übergegangen sein, die absolut keine Fehler, Abkürzungen oder andere sprachliche Hinweise enthalten. Und das geschah über Nacht.

Doch Spam-E-Mails sind nicht der einzige Aspekt der Cybersicherheit, der von der zunehmenden Beliebtheit dieser Bots betroffen ist. Ein weiteres sehr interessantes Merkmal dieser Bots oder Sprachmodelle ist die Tatsache, dass es für diese Systeme ein Leichtes ist, Text von einer Sprache in eine andere zu übersetzen. Sie geben einen Text in einer Fremdsprache ein, mit der Sie nicht vertraut sind, und geben denselben Text in perfekt lesbarer Form aus. Dabei handelt es sich nicht nur um eine direkte Übersetzung, sondern das System versteht (in der Regel) auch den Kontext und liefert wesentlich aussagekräftigere Texte als frühere automatische Übersetzungssysteme. Dies hat den weniger offensichtlichen Aspekt, dass ein solches System Computercode in einfaches Englisch übersetzen kann. Ja, ein Computercode ist einfach eine andere Sprache mit einem anderen Regelwerk. In der Tat sind alle Computerprogrammiersprachen genau das - ein Satz von Regeln. Und die Bots lernen die Regeln leicht.

Was bedeutet das genau? Wenn Sie den Code einer Binärdatei zurückentwickeln, erhalten Sie eine Erklärung im Klartext, Zeile für Zeile, wenn Sie möchten. Erfahrene Programmierer können Ihnen sagen, dass dies unerhört ist und einer der Gründe, warum Reverse Engineering eine dunkle Kunst ist. Für Menschen ist es sehr mühsam, Code zu verstehen, zu verstehen und zu erklären, den sie nicht selbst geschrieben haben - oder den sie sogar erst vor ein paar Monaten geschrieben haben. Die Bots haben dieses Problem nicht.

Wie wirkt sich dies nun auf die Cybersicherheit aus? Zunächst einmal haben die blauen Teams ein großartiges neues Werkzeug für ihr Arsenal. Sie haben einen neuen Malware-Stamm gefunden, den Sie nicht identifizieren können? Füttern Sie einen Bot mit dem Code, und er wird Ihnen erklären, was er tut. Möchten Sie verstehen, wie die Anwendung eines Mitbewerbers funktioniert? Brauchen Sie Hilfe, um die ACLs und Firewall-Regeln eines bestimmten Netzwerkgeräts zu verstehen?

Es dauert nur ein paar Augenblicke.

Umgekehrt gilt das Gleiche. Möchten Sie eine neue Reverse Shell schreiben, die Sie auf einen entfernten Server hochladen können? Etwas noch nie Dagewesenes, das von EDR-Systemen nicht erkannt wird und keine Warnungen auslöst? Geben Sie dem Bot die richtige Aufforderung, und schon ist der Code fertig.

KI-Bots der aktuellen Generation sollten eigentlich über Schutzmechanismen verfügen, um solche Ausgaben zu vermeiden, aber es hat sich herausgestellt, dass diese Schutzmechanismen durch geschickt konstruierte Eingabeaufforderungen umgangen werden können.

Die Panne in der Matrix

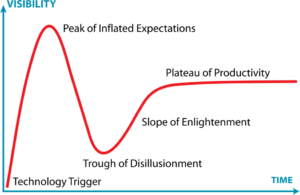

Es ist jedoch nicht alles perfekt im Land der KI. Wir reiten immer noch auf der Hype-Welle mit diesen neuen Bots, aber wie bei allem in der IT werden Realitätsprüfungen die Erwartungen etwas dämpfen.

Im Fall von KI-Bots wird der Hype wahrscheinlich abnehmen, wenn die Mängel deutlicher werden.

In erster Linie sind die Daten, auf denen die Bots trainiert wurden und aus denen sie die Regeln gelernt haben, verzerrt. Dies ist bei allen Plattformen für maschinelles Lernen unvermeidbar und zu erwarten. Das bedeutet, dass auch alle Ergebnisse von Chatbots von Natur aus verzerrt sind. Und damit meine ich nicht die üblichen menschlichen Vorurteile wie Vorurteile, Repräsentation und andere unerwünschte Verhaltensweisen - die gibt es auch. Ich meine die Verzerrungen, die dadurch entstehen, dass das Programm auf einer (offensichtlich) begrenzten Datenmenge trainiert wurde. Dadurch wird die Bandbreite der möglichen Antworten auf eine bestimmte Frage eingeschränkt.

Der andere sehr harte Realitätscheck ist, dass KI-Bots keine Expertensysteme sind. Tatsächlich wissen sie absolut nichts Genaues - gar nichts. Fragen Sie einen der Bots der aktuellen Generation nach einer bestimmten Information, und Sie werden wahrscheinlich eine falsche oder zumindest ungenaue Antwort erhalten. Sie sind sehr gut darin, das nächste Wort gemäß den Regeln vorherzusagen, aber sie werden sich nicht an eine Tatsache "erinnern". Fragt man sie nach einer URL zu einem bestimmten Thema, so erstellen sie spontan eine völlig korrekte URL. Aber sie wird genauso wahrscheinlich fehlerhaft sein, wie sie gerade erfunden wurde.

Die Erstellung von Inhalten durch einen KI-Bot - sei es Text, Bilder, Code oder was auch immer - schließt eine menschliche Validierung nicht aus. Sie müssen immer noch ein gewisses Fachwissen über das Thema haben, um die Probleme zu erkennen. Die Antworten sind auf den ersten Blick einwandfrei, aber falsch. Zum Beispiel so falsch, dass Stack Overflow bereits KI-generierte Antworten verbannt hat, weil sie so oft falsch waren.

Und dabei sind Aspekte wie digitale Rechte, Rechenschaftspflicht oder Verantwortung noch gar nicht berücksichtigt. Wem gehört eine KI-generierte Antwort? Wer ist für die Behebung von Problemen verantwortlich, die sich aus einer schlechten Antwort ergeben? Wem gehört ein neues, von der KI generiertes Bild?

Schlussbemerkungen

Wir leben in einer neuen und faszinierenden Ära der IT. KI wird uns zum ersten Mal nach so vielen Fehlstarts endlich in die Nähe von tatsächlich nutzbaren Interaktionen auf Science-Fiction-Niveau bringen. Sie hat das Potenzial, die Produktivität um Größenordnungen zu steigern, vor allem bei regelbasierten Aktivitäten - und das sind die meisten -, bei denen man, anstatt die eigentliche Aufgabe zu erledigen, einfach den Bot auffordert und die Ausgabe validiert. In unserem Bereich der Cybersicherheit gilt dies unmittelbar für die Programmierung, die Bedrohungsanalyse, die Schwachstellenprüfung oder die Systembewertung.

Aber bedenken Sie, dass keiner der frei verfügbaren KI-Bots dieser Generation internetfähig ist. Das ist kein Zufall. Die Sicherheitsimplikationen eines Systems, das auf Aufforderung Verhaltensweisen auf Systemen Dritter auslösen kann, sind für viele beängstigend, auch für die Unternehmen, die hinter den KI-Bots stehen. Die Sicherheitsvorkehrungen gegen rassistische Voreingenommenheit, Vorurteile und Diskriminierung sind leicht zu manipulieren, ebenso wie die Sicherheitsvorkehrungen gegen böswillige Ausgaben (z. B. die Generierung von Malware), und niemand möchte der erste sein, der einen von einem KI-Bot initiierten Denial-of-Service-Angriff auf seiner Plattform erlebt. Oder eine von einem KI-Bot initiierte Sicherheitsprüfung. Oder ein KI-Hacker.

Sicherlich suchen die Anbieter von Sicherheitslösungen nach Möglichkeiten, KI in ihre Systeme zu integrieren. Wie könnten sie auch nicht? Aber erinnern Sie sich an die oben erwähnte Voreingenommenheit? Wenn Ihre neue KI-gestützte Sicherheitslösung dazu neigt, Dinge auf eine bestimmte Art und Weise zu erklären, könnte sie die Daten übersehen oder falsch interpretieren. Wie sehr oder wie wenig das ins Gewicht fällt, hängt ganz von der Situation ab, aber die Ergebnisse sollten mit einer sehr ungesunden Prise Salz versehen werden.

Dokumentation

Dokumentation Anmeldung

Anmeldung