La IA y el panorama de la ciberseguridad

En los últimos meses se han publicado innumerables artículos sobre los nuevos bots de chat de IA y, desde que estos bots se pusieron a disposición del público, se han realizado muchas demostraciones interesantes y emocionantes basadas en estos sistemas.

Pero, y siempre hay un "pero", hay algunas consideraciones muy preocupantes desde el punto de vista de la ciberseguridad, tanto en la propia infraestructura de los bots como en los (ab)usos que pueden derivarse de ellos.

¿Bots de chat o jugadores con mucha suerte?

"Robots" es un término que tiene muchas implicaciones. De nuestra experiencia colectiva con robots, primero con ejemplos de ciencia ficción y luego con los sistemas robóticos realmente desplegados en distintos sectores, "esperamos" que los (ro)bots sean capaces, como mínimo, de realizar tareas repetitivas autónomas de forma predecible.

Los bots de chat, en cambio, se comportan de forma ligeramente distinta. Un día puedes pedirles "una introducción a la próxima Moby Dick" y obtener un resultado, y al día siguiente -o dos minutos más tarde- la misma pregunta te dará resultados radicalmente distintos. No es así como se espera que se comporten los robots.

¿Por qué? Pues bien, resulta que los "bots de chat" son, en el fondo, modelos lingüísticos de aprendizaje automático glorificados. En términos sencillos, son muy buenos identificando reglas como la "gramática" y "adivinando" qué "palabra" es probable que siga en un contexto determinado. Seguro que te has fijado en que "gramática", "adivinar" y "palabra" van entre " ". Es porque el término se aplica a reglas similares en la edición de imágenes, sonido o vídeo, igual que para el texto. El mismo modelo conversacional en el que se basa la actual generación de bots de chat es igual de capaz de generar una imagen a partir de una indicación que un párrafo de texto. Todo es cuestión de reglas y de adivinar qué es lo que mejor se ajusta a ellas.

¿Cómo se explican las diferentes respuestas a las mismas preguntas? Bueno, "adivinar" lo que viene a continuación no es más que eso: buscar probabilidades y encontrar la que mejor se ajuste a una pregunta determinada. Y eso puede cambiar, y de hecho cambia, con el tiempo, a medida que el robot se entrena con más datos, o las interacciones humanas reducen el valor de una respuesta determinada sobre otra, o incluso el simple azar hace de las suyas. Cualquiera que haya jugado alguna vez en un casino sabe que una probabilidad de ganar del 90% significa que el 10% de las veces se pierde.

Los robots son extraordinariamente buenos aprendiendo las reglas.

Las reglas del juego

La ciberseguridad es, en esencia, un juego basado en reglas. Tienes sistemas/software/personas que siguen una serie de reglas, y tienes otro grupo de sistemas/software/personas que intentarán explotar las reglas del primer grupo para obtener algún beneficio.

Por ejemplo, el spam y el phishing. Todo el mundo los ha visto, todo el mundo los recibe, y es de esperar que los filtros de spam mantengan alejados a la mayoría de ellos, pero alguno que otro se cuela. Los filtros de spam buscan señales que indiquen que un correo es spam. reglas y los que lo consiguen se las arreglan para romperlas o evitarlas. Tanto si los filtros de spam tienen reglas explícitas que definen los mensajes que deben bloquearse como si tienen un enfoque heurístico, no dejan de ser reglas. En el segundo caso, las reglas no se crean directamente.

Una de las razones por las que los correos spam han sido relativamente fáciles de detectar y bloquear son los (muchos) errores gramaticales obvios: no, su banco no quiere "el número de su tarjeta de crédito y el identificador de verificación". Así que se podían marcar los correos electrónicos simplemente ejecutando correctores ortográficos en el texto que contenían.

Pero, ahora, los bots disponibles gratuitamente pueden escribir textos sin esos errores. Podríamos haber pasado de marcar correos mal escritos a marcar correos que no tienen absolutamente ningún error, abreviatura u otro tipo de lenguaje. Y esto ha ocurrido de la noche a la mañana.

Pero los correos spam no son el único aspecto de la ciberseguridad afectado por el aumento de la popularidad de estos bots. Otra característica muy interesante de estos bots, o modelos lingüísticos, es lo fácil que les resulta traducir texto de un idioma a otro. Entra un texto en un idioma extranjero con el que no estás familiarizado, y sale el mismo texto perfectamente legible. Más que una simple traducción directa, (normalmente) entenderá el contexto y proporcionará un texto significativamente más significativo que los anteriores sistemas de traducción automática. Esto tiene el aspecto menos obvio de permitir que un sistema de este tipo traduzca código informático a inglés sencillo. Sí, un código informático es simplemente otro lenguaje, con otro conjunto de reglas. De hecho, todos los lenguajes de programación informática son exactamente eso: un conjunto de reglas. Y los robots aprenden reglas fácilmente.

¿Qué significa esto exactamente? Bueno, entra el código de ingeniería inversa de un archivo binario y sale una explicación en texto plano de lo que hace, línea por línea si así lo deseas. Como le dirán los programadores experimentados, esto es inaudito, y una de las razones por las que la ingeniería inversa es un arte oscuro. A los humanos les cuesta mucho esfuerzo entender, razonar y explicar un código que no han escrito, o que incluso han escrito hace unos meses. Los bots no tienen ese problema.

¿Cómo afecta esto a la ciberseguridad? En primer lugar, los equipos azules disponen de una nueva herramienta para su arsenal. ¿Has encontrado una nueva cepa de malware que no puedes identificar? Dale el código a un bot y te explicará lo que hace. ¿Le interesa saber cómo funciona la aplicación de un competidor? ¿Necesita ayuda para entender las ACL y las reglas del cortafuegos de un determinado equipo de red?

No llevará más que unos instantes.

Y lo contrario también es cierto. ¿Quiere escribir una nueva shell inversa que pueda subir a un servidor remoto? ¿Algo nunca visto que los sistemas EDR no detectarán y no activarán ninguna alerta? Dale al bot el prompt adecuado y saldrá el código.

Se supone que los robots de IA de la generación actual cuentan con protecciones para evitar generar este tipo de resultados, pero se ha descubierto que los mensajes creados con astucia son capaces de burlar las protecciones.

El fallo en la matriz

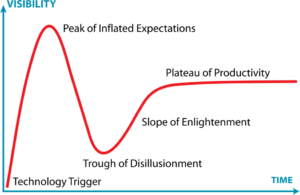

Sin embargo, no todo es perfecto en el mundo de la IA. Todavía estamos en la cresta de la ola con estos nuevos robots, pero como ocurre con todo en TI, la realidad amortiguará un poco las expectativas.

En el caso de los robots de inteligencia artificial, es probable que la expectación disminuya a medida que se hagan más evidentes sus deficiencias.

En primer lugar, los datos con los que se entrenaron los robots, de los que aprendieron las reglas, están sesgados. Esto es inherentemente inevitable y esperado en todas las plataformas de aprendizaje automático. Lo que esto significa es que todos los resultados procedentes de los bots de chat también son inherentemente parciales. Y no me refiero a los sesgos humanos habituales, como los prejuicios y la representación, y otros comportamientos indeseados variados, que también existen. Me refiero a sesgos en el sentido de que se ha entrenado sobre una muestra (obviamente) limitada de datos. Esto limitará el abanico de posibles respuestas a una pregunta determinada.

La otra dura prueba de realidad es que los robots de IA no son sistemas expertos. De hecho, no conocen absolutamente ningún dato concreto. Pregunte a cualquiera de los bots de la generación actual por un dato concreto y lo más probable es que obtenga una respuesta errónea o, al menos, inexacta. Son muy buenos prediciendo la siguiente palabra según las reglas, pero no "recordarán" un hecho. Pídele una URL para algo y creará, sobre la marcha, una URL perfectamente correcta. Pero es igual de probable que esté rota, como que se la acabe de inventar.

La creación de contenidos mediante bots de IA -ya sea texto, imágenes, código o cualquier otra cosa- no excluye la validación humana. Sigue siendo necesario tener conocimientos sobre el tema para detectar los problemas. Las respuestas serán impecables a primera vista, pero erróneas. Por ejemplo, tan erróneas que Stack Overflow ya prohibió las respuestas generadas por IA porque a menudo eran incorrectas.

Y esto sin mencionar aspectos como los derechos digitales, la rendición de cuentas o la responsabilidad. ¿A quién pertenece una respuesta generada por IA? ¿Quién es responsable de solucionar los problemas derivados de una mala respuesta? ¿A quién pertenece una nueva imagen generada por IA?

Observaciones finales

Vivimos una nueva y fascinante era de la informática. La IA, por primera vez después de tantos comienzos en falso, nos acercará por fin a interacciones realmente utilizables, a nivel de ciencia ficción. Tiene el potencial de aumentar la productividad en órdenes de magnitud, especialmente en actividades basadas en reglas -y la mayoría lo son- en las que, en lugar de realizar la tarea en sí, basta con preguntar al robot y validar el resultado. En nuestro campo de la ciberseguridad, esto se aplica inmediatamente a la programación, el análisis de amenazas, las pruebas de vulnerabilidad o la evaluación de sistemas.

Pero hay que tener en cuenta que ninguno de los robots de IA disponibles gratuitamente en esta generación tiene acceso a Internet. No es casualidad. Las implicaciones de seguridad de tener un sistema que puede, en un momento dado, iniciar comportamientos en sistemas de terceros son aterradoras para muchos, incluidas las empresas detrás de los robots de IA. Las salvaguardas contra los prejuicios raciales y la discriminación han sido fácilmente manipuladas, las salvaguardas contra las salidas maliciosas (como la generación de malware) también, y nadie quiere ser el primero en tener un ataque de denegación de servicio iniciado por un bot de IA en su plataforma. O que un robot de IA inicie un sondeo de seguridad. O un hacker de IA.

Sin duda, los proveedores de soluciones de seguridad están buscando formas de integrar la IA en sus sistemas. ¿Cómo podrían no hacerlo? Pero, ¿recuerda el sesgo mencionado anteriormente? Si su nueva solución de seguridad basada en IA tiende a explicar las cosas de una manera determinada, puede pasar por alto o malinterpretar los datos. Lo mucho o poco que esto importe dependerá de la situación, pero los resultados deben venir con una pizca de sal muy poco saludable.

Documentación

Documentación Inicio de sesión

Inicio de sesión