L'IA et le paysage de la cybersécurité

Ces derniers mois, d'innombrables articles ont été publiés sur les nouveaux "chat bots" d'IA et, depuis que ces "chat bots" sont devenus accessibles au public, de nombreuses démonstrations intéressantes et passionnantes ont été réalisées à partir de ces systèmes.

Mais, et il y a toujours un "mais", il y a des considérations très inquiétantes du point de vue de la cybersécurité, à la fois dans l'infrastructure des robots elle-même et dans les (ab)utilisations qui peuvent en découler.

Chat "bots" ou joueurs très chanceux ?

Le terme "robot" a de nombreuses implications. D'après notre expérience collective des robots, d'abord avec des exemples de science-fiction, puis avec les systèmes robotiques réellement déployés dans différents secteurs, nous nous attendons à ce que les "robots" soient capables, au minimum, d'effectuer des tâches répétitives autonomes de manière prévisible.

Les robots de conversation, quant à eux, se comportent de manière légèrement différente. Un jour, vous pouvez leur demander "une introduction au prochain Moby Dick" et obtenir un résultat, et le lendemain - ou deux minutes plus tard d'ailleurs - la même demande vous donnera des résultats radicalement différents. Ce n'est pas ainsi que l'on s'attend à ce que les robots se comportent.

Pourquoi, me direz-vous ? Eh bien, il s'avère que les "chat bots" sont, à la base, des modèles linguistiques d'apprentissage automatique glorifiés. En termes simples, ils sont très doués pour identifier des règles telles que la "grammaire" et pour "deviner" quel "mot" est susceptible de suivre dans un contexte donné. Vous avez certainement remarqué que les termes "grammaire", "deviner" et "mot" se trouvaient entre " ". C'est parce que ce terme s'applique à des règles similaires dans l'édition d'images, le son ou la vidéo, tout comme dans le texte. Le même modèle conversationnel qui sous-tend la génération actuelle de robots de conversation est tout aussi capable de générer une image à partir d'une invite qu'un paragraphe de texte. Tout est question de règles et de deviner ce qui correspond le mieux à ces règles.

Comment cela explique-t-il les différentes réponses aux mêmes questions ? Eh bien, "deviner" ce qui vient ensuite n'est rien d'autre que cela : examiner les probabilités et trouver la meilleure réponse pour un message donné. Et cela peut changer, et change effectivement, au fil du temps, à mesure que le robot s'entraîne sur davantage de données, que les interactions humaines réduisent la valeur d'une réponse donnée par rapport à une autre, ou même que le simple hasard fait son œuvre. Quiconque a déjà joué au casino sait qu'une probabilité de gain de 90 % signifie que dans 10 % des cas, vous perdrez.

Les robots sont extraordinairement doués pour apprendre les règles.

Les règles du jeu

La cybersécurité est, à la base, un jeu basé sur des règles. Vous avez des systèmes/logiciels/personnes qui suivent un ensemble de règles, et vous avez un autre groupe de systèmes/logiciels/personnes qui essaieront d'exploiter les règles du premier groupe pour en tirer un certain profit.

Prenons l'exemple des spams et des courriels d'hameçonnage. Tout le monde les a vus, tout le monde les reçoit et, avec un peu de chance, les filtres anti-spam en éliminent la plupart, mais il y en a toujours un qui passe. Les filtres anti-spam recherchent les signes révélateurs du caractère indésirable d'un courrier électronique - ils appliquent un ensemble de règles et ceux qui passent au travers parviennent à enfreindre ou à contourner ces règles. Que les filtres anti-spam aient des règles explicites définissant les courriels à bloquer ou une approche heuristique sophistiquée, il s'agit tout de même de règles. Dans le second cas, les règles ne sont pas créées directement.

L'une des raisons pour lesquelles les spams sont relativement faciles à repérer et à bloquer est la présence de (nombreuses) fautes de grammaire évidentes - non, votre banque ne veut pas "votre numéro de carte de crédit et votre numéro de vérification". Vous pouviez donc repérer les courriels simplement en utilisant des correcteurs orthographiques sur le texte qu'ils contenaient.

Mais aujourd'hui, des robots librement accessibles peuvent rédiger des textes ne comportant aucune erreur de ce type. Il se peut que nous soyons passés de la signalisation de courriels mal écrits à la signalisation de courriels ne contenant absolument aucune erreur, abréviation ou autre particularité linguistique. Et cela s'est produit du jour au lendemain.

Mais les spams ne sont pas le seul aspect de la cybersécurité touché par la popularité croissante de ces robots. Une autre caractéristique très intéressante de ces robots, ou modèles linguistiques, est la facilité avec laquelle ces systèmes peuvent traduire un texte d'une langue à l'autre. Il suffit d'insérer un texte dans une langue étrangère qui ne vous est pas familière pour que le même texte soit restitué dans une version parfaitement lisible. Plus qu'une simple traduction directe, le système comprendra (généralement) le contexte et fournira un texte beaucoup plus significatif que les systèmes de traduction automatique précédents. L'aspect le moins évident est qu'un tel système peut traduire un code informatique en anglais simple. Oui, un code informatique est simplement une autre langue, avec un autre ensemble de règles. En fait, tous les langages de programmation informatique sont exactement cela : un ensemble de règles. Et les robots apprennent facilement les règles.

Qu'est-ce que cela signifie exactement ? Le code de rétro-ingénierie d'un fichier binaire est introduit, et il en ressort une explication en texte clair de ce qu'il fait, ligne par ligne si vous le souhaitez. Les programmeurs chevronnés vous diront que c'est du jamais vu et que c'est l'une des raisons pour lesquelles la rétro-ingénierie est un art obscur. Il faut beaucoup d'efforts aux humains pour comprendre, raisonner et expliquer un code qu'ils n'ont pas écrit - ou qu'ils ont même écrit il y a quelques mois. Les robots n'ont pas ce problème.

En quoi cela affecte-t-il la cybersécurité? Tout d'abord, les équipes "bleues" disposent d'un nouvel outil formidable dans leur arsenal. Vous avez trouvé une nouvelle souche de logiciel malveillant que vous n'arrivez pas à identifier ? Donnez le code à un robot et il vous expliquera ce qu'il fait. Vous souhaitez comprendre comment fonctionne l'application d'un concurrent ? Vous avez besoin d'aide pour comprendre les ACL et les règles de pare-feu d'un certain équipement réseau ?

Cela ne prendra que quelques instants.

L'inverse est également vrai. Voulez-vous écrire un nouveau "reverse shell" que vous pouvez télécharger sur un serveur distant ? Quelque chose d'inédit que les systèmes EDR ne détecteront pas et qui ne déclenchera aucune alerte ? Donnez au robot la bonne invite et le code apparaît.

Les robots d'IA de la génération actuelle sont censés avoir mis en place des protections pour éviter de générer de tels résultats, mais des messages-guides intelligemment construits se sont révélés capables de contourner ces protections.

La faille dans la matrice

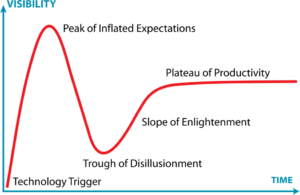

Cependant, tout n'est pas parfait dans le domaine de l'IA. Nous sommes encore sur la vague de l'engouement pour ces nouveaux robots, mais comme pour tout ce qui concerne les technologies de l'information, la réalité viendra quelque peu tempérer les attentes.

Dans le cas des robots d'intelligence artificielle, le battage médiatique diminuera probablement au fur et à mesure que les lacunes deviendront plus évidentes.

Tout d'abord, les données sur lesquelles les robots ont été formés, à partir desquelles ils ont appris les règles, sont biaisées. C'est inévitable et attendu sur toutes les plateformes d'apprentissage automatique. Cela signifie que tous les résultats obtenus par les robots de conversation sont également biaisés par nature. Et je ne fais pas référence aux biais humains habituels tels que les préjugés et la représentation, ainsi qu'à d'autres comportements indésirables - qui existent également. Je veux parler des biais liés au fait que les robots ont été formés à partir d'un échantillon de données (évidemment) limité. Cela limitera l'éventail des réponses possibles à une question donnée.

L'autre réalité très dure est que les robots d'IA ne sont pas des systèmes experts. En fait, ils ne connaissent absolument aucun fait précis. Demandez à n'importe quel robot de la génération actuelle de vous fournir une information spécifique et vous obtiendrez probablement une réponse erronée ou du moins imprécise. Ils sont très doués pour prédire le mot suivant selon les règles, mais ne se "souviendront" pas d'un fait. Demandez à l'un d'entre eux l'URL d'un site et il créera, à la volée, une URL parfaitement correcte. Mais il est tout aussi probable qu'elle soit cassée, car elle vient juste d'être créée.

La création de contenu par un robot d'IA - qu'il s'agisse de texte, d'images, de code ou de toute autre chose - n'exclut pas la validation humaine. Vous devez toujours avoir une certaine connaissance du sujet pour repérer les problèmes. Les réponses seront parfaites à première vue, mais erronées. Par exemple, elles sont tellement fausses que Stack Overflow a déjà interdit les réponses générées par l'IA parce qu'elles étaient souvent fausses.

Et cela n'aborde même pas des aspects tels que les droits numériques, l'obligation de rendre compte ou la responsabilité. À qui appartient une réponse générée par l'IA ? Qui est responsable de la résolution des problèmes résultant d'une mauvaise réponse ? À qui appartient une nouvelle image générée par l'IA ?

Remarques finales

Nous vivons une ère nouvelle et fascinante dans le domaine des technologies de l'information. Pour la première fois, après tant de faux départs, l'IA va enfin nous rapprocher d'interactions réellement utilisables, du niveau de la science-fiction. Elle a le potentiel d'augmenter la productivité de plusieurs ordres de grandeur, en particulier dans les activités basées sur des règles - et c'est le cas de la plupart d'entre elles - où, au lieu d'effectuer la tâche proprement dite, on se contente d'inviter le robot et de valider le résultat. Dans notre domaine de la cybersécurité, cela s'applique immédiatement à la programmation, à l'analyse des menaces, aux tests de vulnérabilité ou à l'évaluation des systèmes.

Mais il faut savoir qu'aucun des robots d'IA de cette génération disponibles gratuitement n'est connecté à l'internet. Ce n'est pas un hasard. Les implications en matière de sécurité d'un système qui peut, à la demande, déclencher des comportements sur des systèmes tiers sont effrayantes pour beaucoup, y compris pour les entreprises à l'origine des robots d'intelligence artificielle. Les mesures de protection contre les préjugés raciaux et la discrimination ont été facilement manipulées, de même que les mesures de protection contre les résultats malveillants (comme la génération de logiciels malveillants), et personne ne veut être le premier à subir une attaque par déni de service initiée par un robot d'IA sur sa plateforme. Personne ne veut être le premier à être victime d'une attaque par déni de service lancée par un robot d'IA sur sa plateforme. Ou un pirate informatique.

Il est certain que les fournisseurs de solutions de sécurité cherchent des moyens d'intégrer l'IA dans leurs systèmes. Comment pourraient-ils faire autrement ? Mais n'oubliez pas les préjugés mentionnés plus haut. Si votre nouvelle solution de sécurité alimentée par l'IA a tendance à expliquer les choses d'une manière particulière, elle peut négliger ou mal interpréter les données. Le degré d'importance de ce facteur dépend entièrement de la situation, mais les résultats devraient être accompagnés d'une pincée de sel très malsaine.

Documentation

Documentation Connexion

Connexion